ファインチューニングのTwitterイラスト検索結果。 86 件中 4ページ目

#VRoid で作ったがおこちゃんを #MagicalTexture で衣装テクスチャを作ってポーズを撮らせてキャプチャし、#WaifuDiffusion を俺の絵柄でファインチューニングしてimg2imgでイラストに仕上げた。めっちゃいい感じ!!

#StableDiffusion

#stablediffusion

躍動感とかフォーカスとかリアル風とか表情とかとか。

特にリアルな絵が難しくて、文脈は汲み取ってくれないから、natural makeやcrop topのように一意でリアルな文脈でしか使わない語彙が大切。それでもかなり限界もあり、ファインチューニングの余地が大きい印象。

stable diffusionでえろ子さんイラストのファインチューニングを実施中。現時点ではまだこんな感じだけど、明日の朝まで放置してどこまでよくなるかなー

AIにアニメ美少女を描かせたいNo.89

#WaifuDiffusion を導入してみました。やはり顔の精度が良いですね。これがファインチューニングの力…

#stablediffusion #AIお絵描き

#イラスト #女の子イラスト

#AIart #animegirl

#AI萌え画

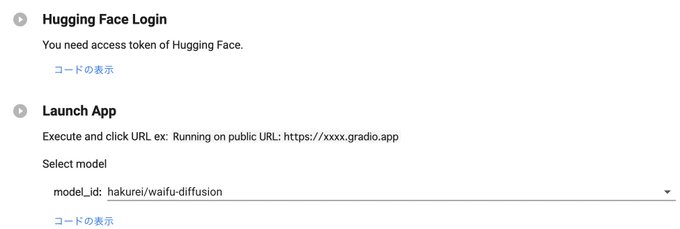

waifu-diffusionなる高品質のアニメ画像で #stablediffusion をファインチューニングしたモデルが出てきたので、Google ColabのGUIツールでモデル選択できるようにしました。

https://t.co/zdqgjlM9mg

某所で話題の waifu-diffusion を↑と同じpromptで出してみた 結構タッチが変わるのと、出てくる顔の崩れてない率が上がっているように思う ファインチューニングで結構変わるんだねぇ #stablediffusion

噂のファインチューニング版waifu-diffusionのモデルが公開され1111版webuiで動かせるようになったのでテスト。キャラクター名だけでここまでとは、やるやん。

#StableDiffusionKawaii #waifudiffusion

ファインチューニング(自分の用意した画像による画風やキャラクターの追加学習)を行いました。ただし何とも言えない結果。

1枚目 通常prompt

2枚目 #waifulabs の系統の絵を学習

3,4枚目が生成(1枚目とほぼ同prompt)

顔の系統は格段に寄ったが学習が足りず精細さに欠ける、という印象です。

なのであくまでファインチューニングしたから指定したキャラの画像を簡単に生成し放題ヒャッホウ、というのは難しそうで、抽象的な特徴をもった要素を追加できるけど、それをうまくアウトプットできるかはプロンプトとそもそもの技術的限界のせめぎあいと思われる。たぶん。 #stablediffusion

ファインチューニングそのものは画像の特徴を抽象的にとらえている、、ような気がする。なのでプロンプトで頭に包丁アクセサリ、とか指定しないときりたん包丁は翼に近しいものとみられている気がする。その辺は元の論文理解してないので感覚的なものやけど

ということでちょっときりたんのファインチューニングを実施。画像は公式イラスト。30 EPOCHぐらいでinit_wordはhuman、girl。結果を読みませてプロンプトいろいろ調整した結果を添付。近しいものも遠そうなものもあるけど、包丁要素=ヤンデレ の修正がかかっている気がする #stablediffusion https://t.co/6I0YnS7yGa

シャドウバースを題材とした、Textual Inversion を用いたファインチューニングと純粋なファインチューニングによる結果の比較。前者は知識を維持しつつ、画風を完全にはコピーできない。後者は画風をコピーしたものの、知識を忘却している。この中間を狙うのがベストかと思われる。

ファインチューニングがローカルで動くようになったので早速テスト!東北ずん子ちゃんを10時間学習させたログを動画にしてみたよ。 左は500ステップごとにAIが学習した画像。右はその時点で生成された画像。学習画像によって急に良くなったり劣化したりを繰り返してて中々難しい!#StableDiffusion https://t.co/rx3jHFMGn8

Stable Diffusionをいらすとやでファインチューニングする巷で話題のStable Diffusion(以下SD)をファインチューニングする方法が公開されたので、早速やります。 https://t.co/ma6Zlablel