T2IのTwitterイラスト検索結果。 1,529 件中 32ページ目

渡り廊下はなんかキャラにならなさそうだったのでmidjourney さんで。v4 t2i無編集。回転数は4枚x10回くらいかな。それっぽいのだけチョイス。#AIart #AIイラスト #midjourney

②NovelAIでi2iアップスケール

t2i画像を元にi2iでアップスケール

Nomal(768×512) → Large(1024×768)

Seedは別のためディテールがけっこう変わってしまう。

なるべく元画像に近い好みの画像を出そうとしていた。

※NovelAI 2月アプデ前の生成

@clock_luna 機能画面は使えるようになったものの説明の通りに反映できているとはいいがたい状況です・・・。

t2iではcontrol poseが反映されず、i2iだと左手がでてきて余計なことされちゃってますw

画像はi2iでやったものですが、1枚目を2枚目のポーズにしたくて出たのが3枚目です。

・・・根気の問題ですかね?

リプの結果からもしかしたらエフェクト多いのや、独創的なイラストに組み込むのはアリかもしれません

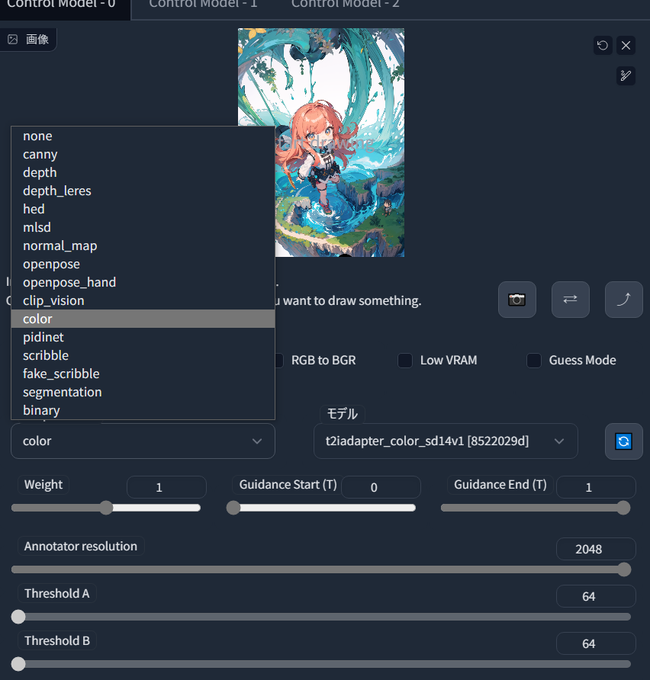

分かりづらいので画像再度張り

1・2枚目:weight「0.7」(t2i)

3枚目:preprocessorをcolorして入れた元絵

4枚目:3枚目が処理されモザイク絵になったもの(これが1・2枚目にcolorとして適用される

T2I-Adapterの一部機能が追加されてました

「clip-vision」「color」「binary」

colorはモザイク画像の色参照して生成出来るようですが、他2つは謎

colorで生成出来そうなのでお試し

1枚目:元絵

2枚目:color適用後(SEED値は1枚目で固定)

3枚目:colorで変換した絵

4枚目:ControlNetでの設定画面

t2i 732x732で出力しレタッチツールで832x832に拡張(上・左右)、近似色で増えた領域を塗りつぶし&境界ぼかし処理後i2i重ねがけ処理。最後に手周辺をInpaintで調整し左右反転も実施して完成 #WaifuDiffusion #AIイラスト

死神のイラスト、実は最初t2iで出した時は以下1枚目みたいな見切れた状態のものでした。

最初はこれでもいいかなーと思ってたのですが、どうにも納得が行かなかったので、

1. イラストソフトでキャンバス拡大

2. 雑塗り後inpaintで擬似アウトペインティング

としたら意外に上手くいってヤッホイ!

@Yamoberus @Elna_ai3 私はあなた方の意見に全面的に賛同するcontrol net使えないマンです。

t2iのAIガチャしかできないけど人生たのしいです。

それでは、お邪魔しました🙇♂️🙇♂️

これでt2iでのやり方は以上になります

比べてみると差が分かりやすいですね

・・・で、このままだとよく読んでない人は多分悲しみ背負う人が出てくるのここからはちょっと細かい解説をします

sd-webui-depth-libについて

・どんなもの?

主目的は手の深度マップ(Depth)をリサイズ・配置し、手の位置調整や修正を簡単に出来ます

※CannyなどDepth以外でKontrolNetで使う画像も後で追加出来ます

簡単に言うと1枚目から2枚目にt2iで出来ます

3・4枚目は操作画面

#KontrolNet #Automatic1111

実験レベルなのでそこまでこだわった品ではないけど、t2iで小さい元絵作ってi2iで拡大してやれば、意外とアップスケーラなしでもイケるんじゃね?っていう気もしてくる。

RTX3060ごときで968x968が生成できるのは心地よいかも。個人的にはこのサイズが好みなので。

#stablediffusion