controlNetのTwitterイラスト検索結果。 1,171 件中 58ページ目

話題のControlNetに触れてみました。

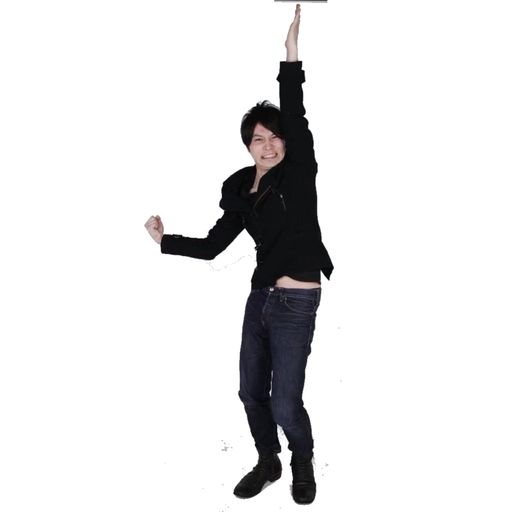

左:元画像の以前生成したイラスト

右:左の画像より生成されたイラスト

確かに同じようなポーズになりますね!

凄いなぁ。。

This is a test of "ControlNet".

I was surprised by the results😱

https://t.co/FnnyS9UJRS

sd webui controlnetのポーズの拡張機能、適当に使ってみた。入力画像がしっかりポーズとして認識されるのがムズいのと、出力画像があまり綺麗ではない。軽く触っただけだし、今後改善されていくとは思うけど。もう寝ます😴 #stablediffusion #AIart #aiイラスト

Latent Couple、どうにか今の絵柄の範囲内に寄せてhires2倍に耐えれたので寝る!

今日も有意義だったしがんばったあ💯

まだControlnetは手付かずだし楽しみ💜

明日も明後日も明々後日も楽しみだよ

Good night晩安おやすみみ🌟

WebUIのSD-WebUI-ControlNetについて

・どんなもの?

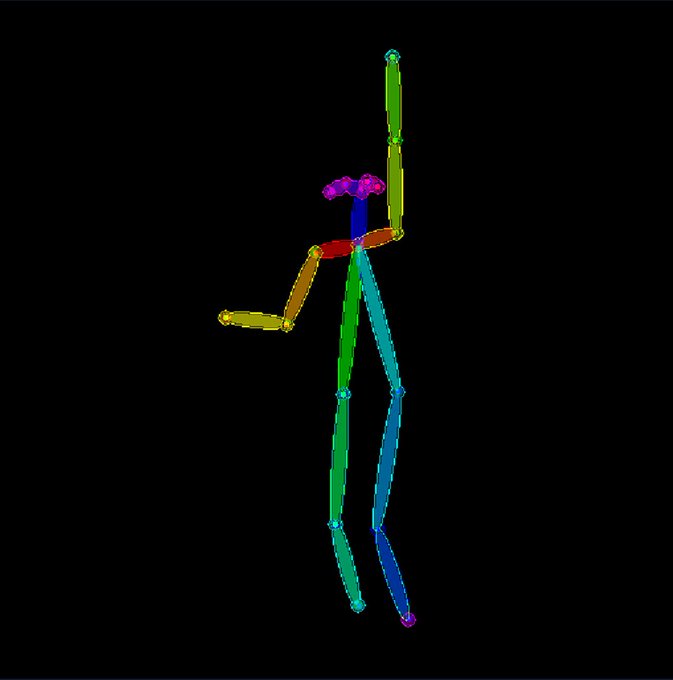

元画像からボーンや輪郭を認識し、それらを参照してt2iで出力できる

・どんな時に使う?

実写や(AI)イラストなどから、似た構図を出力したい時

今回は1枚目→2枚目にする工程を解説します(リプに続きます

#automatic1111 #AIイラスト #AIart

SD-WebUI-ControlNetのお試し

とりあえずPreprocessorとモデルはopenposeを指定しました

ちなみにt2iでポーズ指定は一切してません

1枚目 :参照元画像

2枚目 :1枚目を元にinputされた画像

3・4枚目:実際に生成出来た画像

#automatic1111 #AIイラスト #AIart

LoRAによるControlNet、できた~(・∀・) 1枚目controlなし(i2iもなく普通に生成)、2枚目あり。

公式のCanny EdgeのControlNetとSD1.5の差分をrank 128のLoRAとして抽出してACertaintyに適用、input_hint_blockとzero_convはそのまま使用。

ただかなり効果が弱いので微妙……。