OpenPoseのTwitterイラスト検索結果。 159 件中 7ページ目

@kurisu_Amatist U can use hand detection model in preprocessor with openpose_hand

However, the training data for Hand Pose Estimation may be insufficient. It will improve

https://t.co/jcfTNeySP4

also try drawing hands with other ControlNet models such as Canny, Scribbles, Normal Map & Depth😊

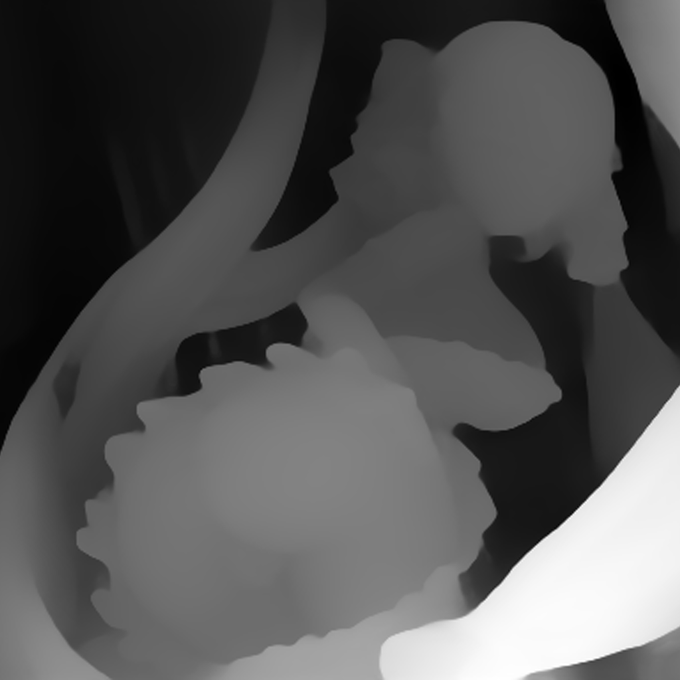

ControlNetのDepth追従性が良い

openposeでは結構見失われてしまう

img2imgだと背景も影響するから弊害が少ないのも良い

ただ生成時間がちょっと増える。

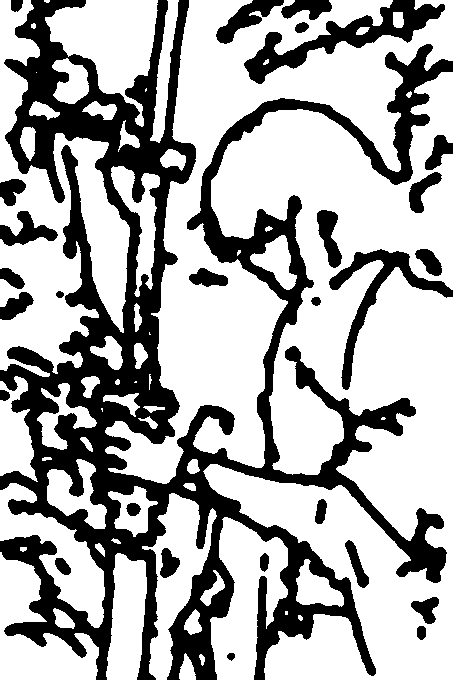

After some fiddling, finally managed to get the ControlNet module to do what I wanted for the 1st time on this test image. Seems the key is to use the Canny preprocessor along with the OpenPose model. The wireframe was generated from https://t.co/IpcHIehKVu #StableDiffusion

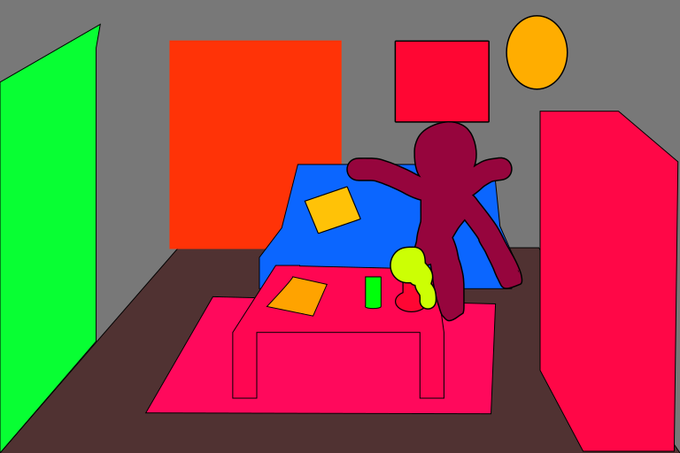

メカ娘飛行形態再び。 #ControlNet (OpenPose+AOM2n用OpenPoseモデル)を使い昨日と異なるポーズでやってみる。

若干助言(前傾姿勢とか)を加えないと変になるかもしれん。

Dynamic Promptsで色などを1枚毎に動的変化させている。

#AbyssOrangeMix3 (AOM3A1) #StableDiffusion #aiart #aiイラスト

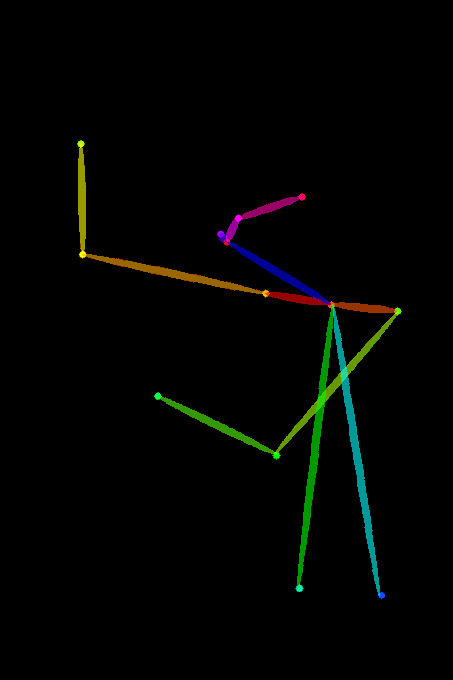

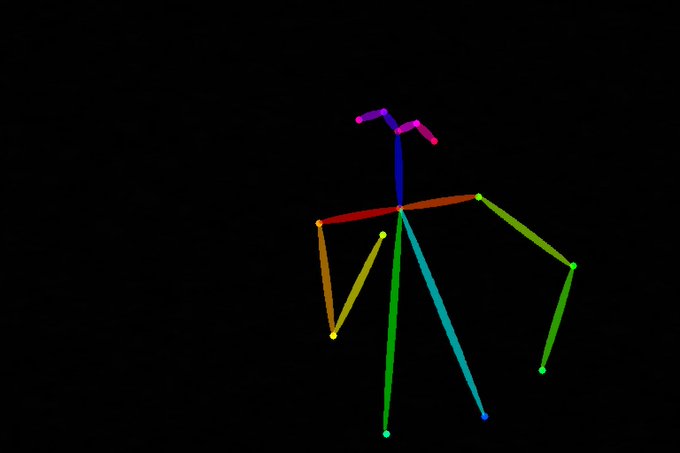

tf-pose-estimationでOpenPose互換の棒人間画像を出力できるようにしました。

sd-webui-controlnetのPreprocessorをnoneにして、この棒人間画像のポーズで画像生成できます。

https://t.co/5JL9uiUr5G

話題のControlNetのOpenPoseを試してみる。割と現時点でパラダイムシフト感があるけど、今の技術発展速度的に数か月後にはもっと凄い技術がでてるのかなぁとも思えるので凄い時代だ。

#ControlNet #stablediffusion

controlnet_depthテスト

openposeはスマホだとvrmのモデル動かせるやつでモデルデータが読み込めないのと、なんかバグったので断念

ようやくぽいのが撮れた。

openposeのボーン調整とLatentCoupleで(((upside down)))して回せる程度にはだいぶ安定させられた。

結局のところ百合太極図はモデル次第だなあ、ということで実験終了

難関「掌でお皿を作るポーズ」にcontrolnetで再挑戦しましたわ。

まず、ボーンを自分で作ってopenposeするも失敗。掌の位置や向き、何より「パース」を理解できないんですわね(3枚目)

今度はscribbleでポンチ絵を描いて生成してみたところ、4枚めが出現。向き不向きがありますわね~。

@lakeside529 @fghjkl71903498 Depthなら悲しきロボは生み出せますがopenposeは無理っぽいですね...(雑ポリゴンのモデル作らないと無理かも)

#AIart #AIイラスト #ControlNet Posex!openpose で使える棒人間画像作れるやつ。 詳細ALT。優秀!推定だ手を顔に重ねるとか苦手なので直ポージング出来ると楽wインストールしたあとにいちいちcmdから起動するのめんどいからbatファイルを用意していつでもワンクリック起動。試してみてね~