OpenPoseのTwitterイラスト検索結果。 159 件中 8ページ目

#stablediffusion

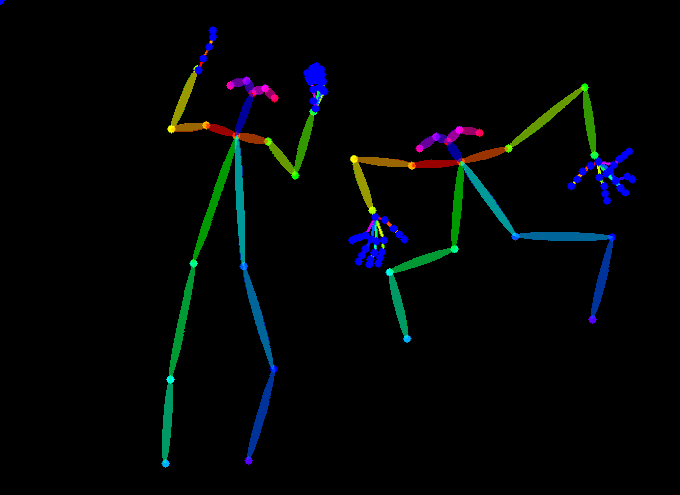

#ControlNet のお試しその2(ACT+AOM2)

①VRoidHubのプレビューをスクショ、②ControlNetのopenposeでポーズ推定、③④推定したポーズを元に「bikini girl」呪文で画像を出力

#stablediffusion

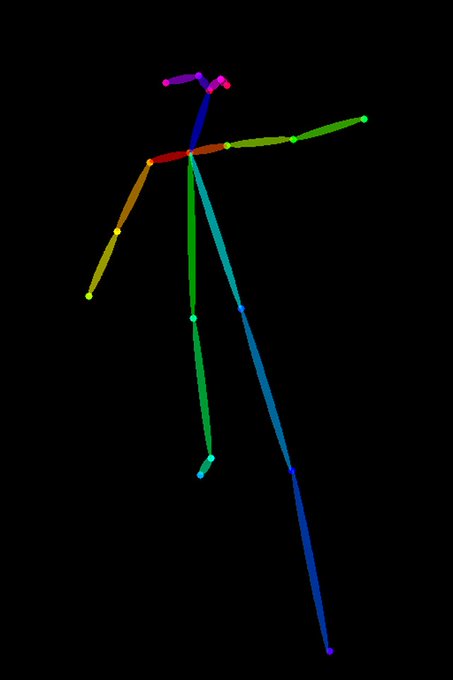

#ControlNet のお試し!

①カスキャで撮影した画像、②ControlNetのopenposeでポーズ推定、③④推定したポーズを元に「bikini girl」呪文で画像を出力

普通に元画像に近い画像が出力されるの凄い…!

モデルはいつものACT+AOM2

#ControlNet #pose2image やってみました。

M1 MacBook Pro使用

Model: control_any3_openpose.pth https://t.co/u7WOBQs1Jv

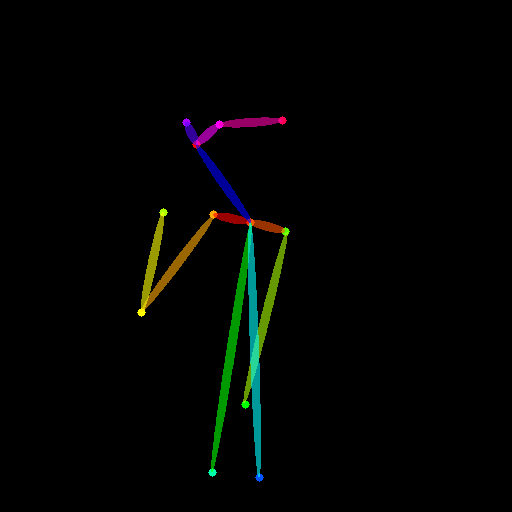

openposeだと再現が難しい構図へのアプローチ

・どういうこと?

openposeはあくまで棒人間的な処理なので、3D(奥行き)の表現は出来ない場合があります

・例えば?

今回は拳を前に突き出すポーズを例にします

2枚目を見れば分かりますが、拳を突き出している手が再現出来ず3枚目のようになります

#06_ And of course, these openpose-like bones can also be retargeted to Mocap. I used Autorig-pro. https://t.co/d5y5izbLn3

あれから何度も鍔迫り合いにチャレンジしましたが、Xに交差する剣はほとんど出ませんでした

↓

openposeは諦めました😡

↓

depthにしよう

↓

どうせなら剣まで3Dで用意しちゃえ

↓

できた(驚愕)

↓

多分これが一番早いと思います

↓

AIイラストってなんだっけ?🤔

#AIイラスト

Cloabでも無事ControlNet(ミクビル版)を導入できました~お試しに大昔に生成した子から棒人間(openpose)を……

---

git cloneにてInstall from URLを、

wgetにてモデルをぶち込むのがミソでした

AIイラスト

Testing Control net (openpose preprocessor), it seems i got some conflicts in the quality of images it generates, but the pose looks fine🤔

#AIart #AIイラスト #AIArtwork #ControlNet

んでその流れでさっきのopenposeの追加版のopenhandって機能も試しているのですが、割と認知が微妙ではあるのでこの辺は様子見かなぁ。 あとクリスタのデッサン人形だと全然認識しないこともあればキャラモデルでもダメな場合もあるので写真のほうが確実性は高そう。

SD-WebUI-ControlNetのお試し

とりあえずPreprocessorとモデルはopenposeを指定しました

ちなみにt2iでポーズ指定は一切してません

1枚目 :参照元画像

2枚目 :1枚目を元にinputされた画像

3・4枚目:実際に生成出来た画像

#automatic1111 #AIイラスト #AIart

tf-openposeをPythonからC++に書き換えてTensorFlowのC++ APIから叩く、というやつを試してみてます。ひとまずヒートマップ周りだけ組み込んだ段階だと添付画像のような感じです。とりあえずは動いてるっぽい。