ControlNetのTwitterイラスト検索結果。 1,175 件中 49ページ目

3Dモデルからイラストまで。(ControlNet +depth)

いろいろな使い方ができそう。

#AIArt #AIArtwork #AIイラスト #StableDiffusion #DefmixV1

#ControlNet is Impressive. https://t.co/LnTAqE7BsS

Tried 3 different artist styles

by C215 https://t.co/oRGABSzS22

by Alice Neel https://t.co/dQVEh0gpm9

by Canaletto https://t.co/g5y3fnSBDB https://t.co/KpJFu9stLE

ControlNetの実験2。

相方のラフ作品を借りて自動着色。

表情は変わってしまっているけど、今の自分レベルのプロンプトでここまで塗れるとなると、プロンプト突き詰めると化けるねこれは。

Anything3.0+canny

うーーーん。なんか絵柄前と変わった気がする。原因の切り分けもしたいので、ちょっと調査が必要かもですね。゚(゚´ω`゚)゚。

#AIイラスト

#ControlNet

#絵柄が好みって人にフォローされたい

ControlNet depth test: unexpected...🤔#AIイラスト Prompt👇

https://t.co/wSn45enmEd

mocopiでモーキャプした動きを使って、私のパーカー姿をControlNetに食わせてイラストにしてみた!

とりあえず適当にボーン割り当てたけど、おもしろー!

#ControlNet scribbling is so much fun. Unfortunately I failed to save my trackpad scribbles 🤦♂️ But here is a thread with outputs generated from a custom dreambooth model of mine. Each group had the same underlying scribble.

ホントは片手目隠しにしたかった。

「手で目隠し」+「踏みつけ」の構図は難易度高すぎました。。

ControlNetでリベンジする…かも

「目隠しメスガキの踏みつけ」

#AIイラスト #AIart

#AIイラスト好きさんと繋がりたい

#ちちぷい #AIピクターズ にも投稿しました。

難関「掌でお皿を作るポーズ」にcontrolnetで再挑戦しましたわ。

まず、ボーンを自分で作ってopenposeするも失敗。掌の位置や向き、何より「パース」を理解できないんですわね(3枚目)

今度はscribbleでポンチ絵を描いて生成してみたところ、4枚めが出現。向き不向きがありますわね~。

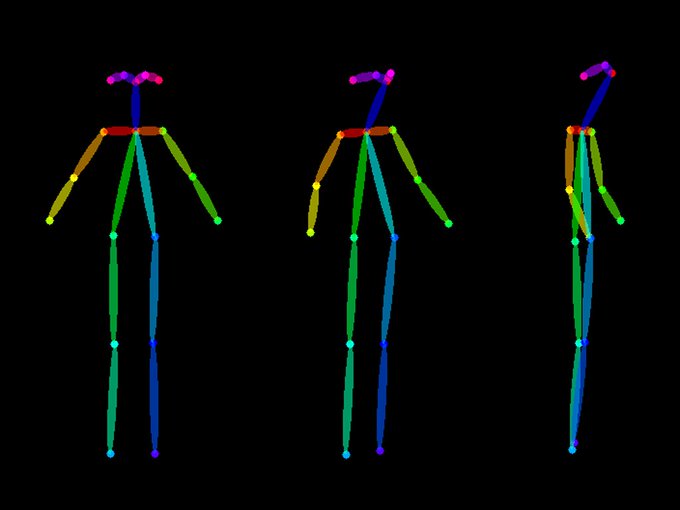

Experiments with ControlNet. This version takes an image, extracts a pose, and uses that pose to guide #RetroDiffusion image generation.

Absolutely insane, this might lead to easy animation.

This is just ONE of EIGHT input options!