ProcessorのTwitterイラスト検索結果。 214 件

HSPプログラムコンテスト2024

今年もイラストを描かせていただきました。

無料のプログラム言語HSP(Hot Soup Processor)を使った自作プログラムの祭典です。

よかったら参加してくださいね。(^^)/

https://t.co/7GlZlGOr8v

https://t.co/PWuGYFF3vf

Rawest line in Castlevania has to be “Lisa, I’m killing our boy” because i shrunk into myself and tumbled into a food processor and was shredded into ground meat when i heard that delivery !!!

@prompt_battle #皆でプロンプトバトル #水着

I don't know why my swimsuit works keep getting canceled, so I just got this one.

A futuristic swimsuit with durable, water-resistant material, advanced sensors and processors

リプの結果からもしかしたらエフェクト多いのや、独創的なイラストに組み込むのはアリかもしれません

分かりづらいので画像再度張り

1・2枚目:weight「0.7」(t2i)

3枚目:preprocessorをcolorして入れた元絵

4枚目:3枚目が処理されモザイク絵になったもの(これが1・2枚目にcolorとして適用される

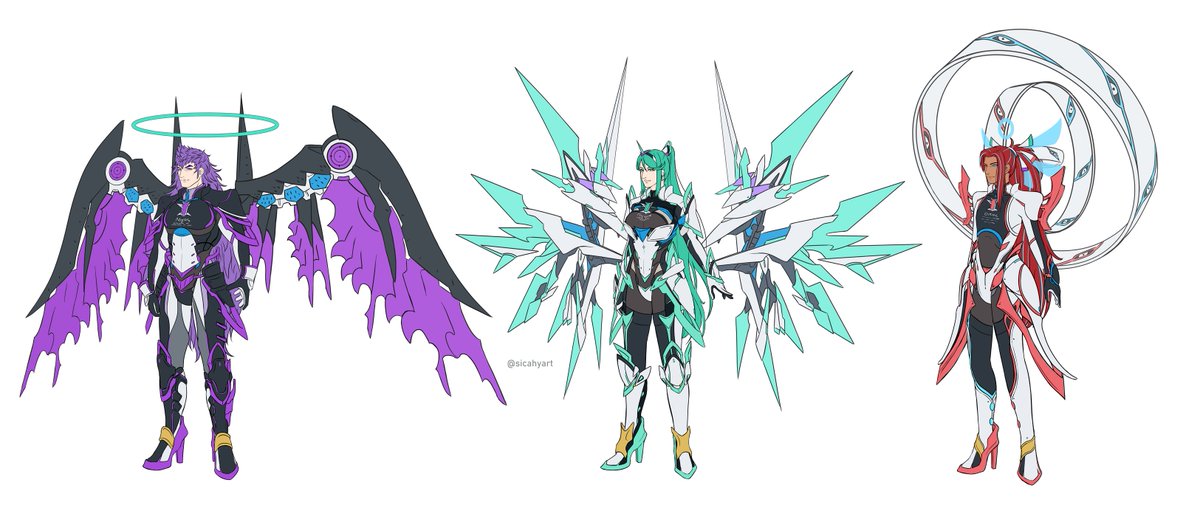

Slot 2, Early 2023 - Ignis Vulcani

2 weeks of no post due to my CPU needing a new processor and delivery getting delayed.

Also Greco-Roman themes here. Appreciate that ♥

Slots are still available if you're interested!

#ArtCommission #DigitalArt #FantasyArt #FireGenasi

COCOPStudioで出力した画像をもとにControlNetで出力してみた。

ポーズとして認識が難しいのはpreprocessorをdepthにして処理させる方が綺麗にでた。

リボンがハートの形になってるの嬉しい!

1枚目:元→2枚目:結果

3枚目:元→4枚目:結果

#AIイラスト #AIart #ControlNet #COCOPStudio

Unlike my modern days of art, I used to draw in Paintdotnet. To save time on Blanc and Vert (since they looked identical aside from the processor), I traced over them and drew their UD Processor overtop. I did it also for other concepts like UD Black Sister & other CGs.

今までControlNetが全然うまくいかず、「マージモデルでは無理なんかな」と諦めてましたが、できました!

カギはpreprocessorをnoneにすることのようです。

こちらを参考にさせて頂きました。

https://t.co/UK5JtP8PMZ

ControlNet完全に見切った。

Preprocessor: canny

モデル: control_canny-fp16

Weight: 0.5とかに下げる ←ここめっちゃ重要

これで同じポーズで別人量産出来る。

@utahara_ruika 別のPreprocessorを通すと、こんなアレンジもできるようです。

#ControlNet #automatic1111 #aiart #AIイラスト

🍩ダヨーさん?あれ?

🐰3枚目のようにpreprocessorをNoneにして、元画像からの深度推定はスキップさせたうえでControlNetへの入力に2枚目の深度画像を指定するとダヨー型の所にかわいらしいダヨーさんダヨー?が描かれました☺️

🚀normalの方はあんまりうまく行きませんでした

@kurisu_Amatist U can use hand detection model in preprocessor with openpose_hand

However, the training data for Hand Pose Estimation may be insufficient. It will improve

https://t.co/jcfTNeySP4

also try drawing hands with other ControlNet models such as Canny, Scribbles, Normal Map & Depth😊

After some fiddling, finally managed to get the ControlNet module to do what I wanted for the 1st time on this test image. Seems the key is to use the Canny preprocessor along with the OpenPose model. The wireframe was generated from https://t.co/IpcHIehKVu #StableDiffusion

tf-pose-estimationでOpenPose互換の棒人間画像を出力できるようにしました。

sd-webui-controlnetのPreprocessorをnoneにして、この棒人間画像のポーズで画像生成できます。

https://t.co/5JL9uiUr5G

ControlNetのScribble Mode(Reverse color)が良いっぽいので線画や下書きではなくラフで精度テスト

Preprocessorはcannyでcontrol_sd15_seg

使用モデルはAbyssOrangeMix2_sfw

Pはキャラのみ、NPは(EasyNegative:1.5)のみ

1枚目:ラフ

2枚目:Weight1(デフォルト)

3枚目:Weight0.6

4枚目:Weight0.2

Testing Control net (openpose preprocessor), it seems i got some conflicts in the quality of images it generates, but the pose looks fine🤔

#AIart #AIイラスト #AIArtwork #ControlNet

リプ元の1枚目を元に、Preprocessorとモデルをhedに変えたもの

プロンプトはリプ元と同じです

1枚目 :リプ元の1枚目からinputされた画像

2~4枚目:実際に生成出来た画像

#automatic1111 #AIイラスト #AIart

SD-WebUI-ControlNetのお試し

とりあえずPreprocessorとモデルはopenposeを指定しました

ちなみにt2iでポーズ指定は一切してません

1枚目 :参照元画像

2枚目 :1枚目を元にinputされた画像

3・4枚目:実際に生成出来た画像

#automatic1111 #AIイラスト #AIart