ちまちまAttention Couple+領域別LoRAを自前スクリプトに実装してたんだけど、やはりWeb UIより楽ですっきりしてる。

そしてキャラが全く混ざらない。Attention Coupleすごい……。

#AIArt

ControlNetのCannyで要所だけ制御して着せ替えする例。生成した画像(1枚目の左)を例に、そこからCannyで処理(中央)、一部を手動で消去(1枚目右)。それを使ってプロンプトを変えつつ生成したのが2~4枚目。

Attention Couple+領域別LoRA、領域の境を64で割り切れる値にするときれいに分かれる(この例では960x640を320x640で三分割)。ただし二人しか出なかったり近づきすぎたりすると混ざるのでControlNetなしだと回数が必要。

Attention Couple+領域別LoRA、一応動くようになった。キャラ3LoRA+画風1LoRA。ControlNetも使える。

ただ、LoRA数とサブプロンプト数は一致する必要がある、positiveとnegativeのトークン数を合わせる必要がある、バッチサイズ1しか動かない、と制約も多い(;・∀・)

@izumisatoshi05 一応試したらDiffusersベース(clip skipは自前で実装)ではclip skipが効きました。clip skip=1 (clip skip未指定=22層)、10です。

領域別LoRA適用、自前スクリプトでは意外に簡単に実装できた。ControlNetと組み合わせて実用的に動きそう。ただ問題はWeb UIへの実装……(;・∀・)

サンプル画像のモデルはACertainThing。

@VGDCMario This is a result without AddNet and embeddings. 2nd image is a line-art image with ControlNet from 1st image.

ControlNetのtransfer control、若干効果ありそう。1枚目はACertaintyにSD15のControlNetをそのまま適用、2枚目はACertainityにtransfer controlして適用。少し線がシャープに。

pull requestを作って出すか、と思ったら作業中みたいだ。どうするかな。

https://t.co/6Fh913MckC

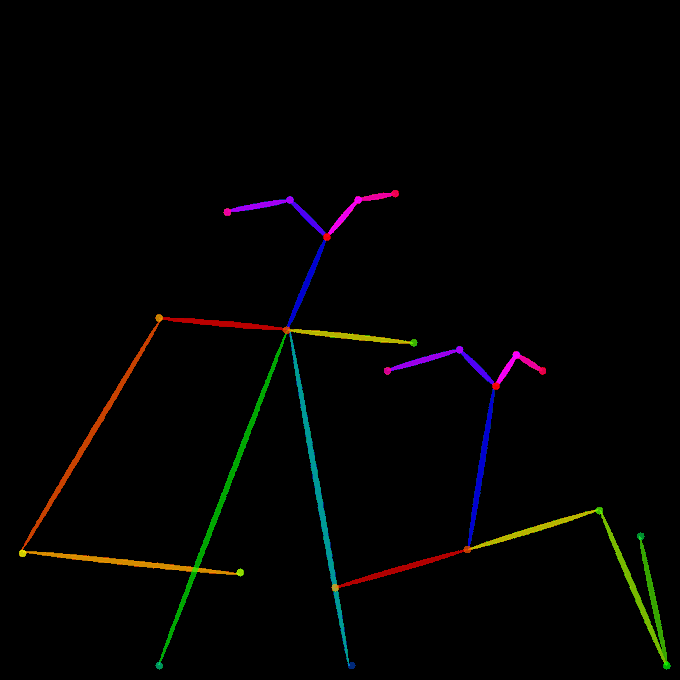

LoRAによるControlNet、できた~(・∀・) 1枚目controlなし(i2iもなく普通に生成)、2枚目あり。

公式のCanny EdgeのControlNetとSD1.5の差分をrank 128のLoRAとして抽出してACertaintyに適用、input_hint_blockとzero_convはそのまま使用。

ただかなり効果が弱いので微妙……。